sharing is caring

ist wirklich so!

Vielen Dank fürs Teilen!

Kluge Köpfe filtern für dich relevante Beiträge aus dem Netz.

Entdecke handverlesene Artikel, Videos und Audios zu deinen Themen.

Wenn wir uns anschauen, warum wir nicht glauben, was uns nicht passt, werden wir uns vermutlich zwischendurch ertappt fühlen - mir ging es jedenfalls so. Es gibt offensichtlich gute Gründe für uns, dass zu glauben, was wir wollen, unabhängig davon, wie richtig oder falsch uns Informationen präsentiert werden.

Was es für Journalisten nicht einfacher macht, uns die Welt zu präsentieren. Zumal auch manchmal Wissenschaftsjournalisten bei bestimmten Themen versucht sind, zu sehr zu vereinfachen und uns Leser aus der Eigenverantwortung zu entlassen, weil es X Studien zum Thema Y gibt, die Z nahelegen, aber eben nicht, unseren Verstand zu gebrauchen. Was vielleicht aber auch zum ersten, oberen Link passt.

Ratlos machen mich gerade aktuelle Forschungen aus dem Bereich des ML (Machine Learning), hier der Texterfassung, -verarbeitung und -generierung.

Verkürzt: Die Forscher füttern ihren Algorithmus mit einer definierten Menge Text, geben dann zwei, von Menschen geschriebene, Sätze vor und lassen nun ihren Algorithmus arbeiten - er soll (ganz vereinfacht) immer das nächste wahrscheinliche Wort anfügen. So entstehen erstaunlich und erschreckend realistische Texte mit, vom Language Model (LM), erfundenen Quellen, Personen und Zitaten, die den ersten ein bis zwei morgendlichen, erstkaffeegestärkten Blicken (und tatsächlich auch Fragen) standhalten und dann ggf. flott via Social Media Verbreitung finden (können).

Diese Möglichkeit (und noch viel mehr sich daraus ergebende) in Kombination mit Deep Fakes macht selbst die Forscher vorsichtig - sie stellen nur ein kleines Sample ihrer Trainingsdaten zur Verfügung. Ich empfehle den englischen Beitrag auf OpenAI, aber in der SZ ist genau hierzu ein guter Beitrag erschienen.

Ich finde diese Forschungsergebnisse gerade jetzt, wo wir uns auch über die Zukunft des Journalismus unterhalten, alarmierend. Bleibt zu fragen, was sich dieser Entwicklung journalistisch entgegen setzen lässt. "...red, was wahr ist." reicht vielleicht nicht mehr.

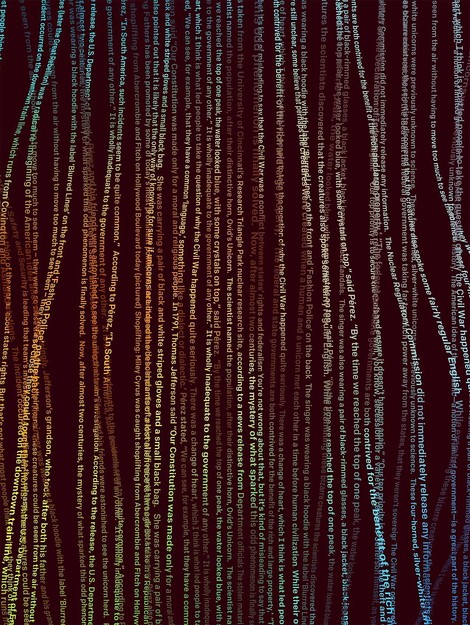

Quelle: Alec Radford, Jeffrey Wu, Rewon Child, David Luan, Dario Amodei, Ilya Sutskever Bild: Ben Barry EN openai.com

Einfach die Hörempfehlungen unserer Kurator'innen als Feed in deinem Podcatcher abonnieren. Fertig ist das Ohrenglück!

Öffne deinen Podcast Feed in AntennaPod:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Apple Podcasts:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Downcast:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Instacast:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Apple Podcasts:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Podgrasp:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Bitte kopiere die URL und füge sie in deine

Podcast- oder RSS-APP ein.

Wenn du fertig bist,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in gpodder.net:

Wenn alles geklappt hat,

kannst du das Fenster schließen.

Öffne deinen Podcast Feed in Pocket Casts:

Wenn alles geklappt hat,

kannst du das Fenster schließen.